Compare commits

19 Commits

| Author | SHA1 | Date |

|---|---|---|

|

|

8ed77ed601 | |

|

|

1fa74952bc | |

|

|

b52dd54cda | |

|

|

ed7901f8db | |

|

|

11af8cd5eb | |

|

|

d1a77e4b48 | |

|

|

1dbb816a79 | |

|

|

9538a6afd1 | |

|

|

8ed2abf2b9 | |

|

|

6d9273985c | |

|

|

b013dbde4b | |

|

|

707f23a776 | |

|

|

ea2fc23a08 | |

|

|

01ab5fd6ef | |

|

|

4ac30a6254 | |

|

|

0f50102ca8 | |

|

|

faf243e53a | |

|

|

8f8d4e34ae | |

|

|

38336217c4 |

Binary file not shown.

|

After Width: | Height: | Size: 4.9 MiB |

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

File diff suppressed because it is too large

Load Diff

|

|

@ -0,0 +1,117 @@

|

||||||

|

---

|

||||||

|

license: apache-2.0

|

||||||

|

tags:

|

||||||

|

- object-detection

|

||||||

|

- vision

|

||||||

|

datasets:

|

||||||

|

- coco

|

||||||

|

widget:

|

||||||

|

- src: https://huggingface.co/datasets/mishig/sample_images/resolve/main/savanna.jpg

|

||||||

|

example_title: Savanna

|

||||||

|

- src: https://huggingface.co/datasets/mishig/sample_images/resolve/main/football-match.jpg

|

||||||

|

example_title: Football Match

|

||||||

|

- src: https://huggingface.co/datasets/mishig/sample_images/resolve/main/airport.jpg

|

||||||

|

example_title: Airport

|

||||||

|

---

|

||||||

|

|

||||||

|

# DETR (End-to-End Object Detection) model with ResNet-50 backbone

|

||||||

|

|

||||||

|

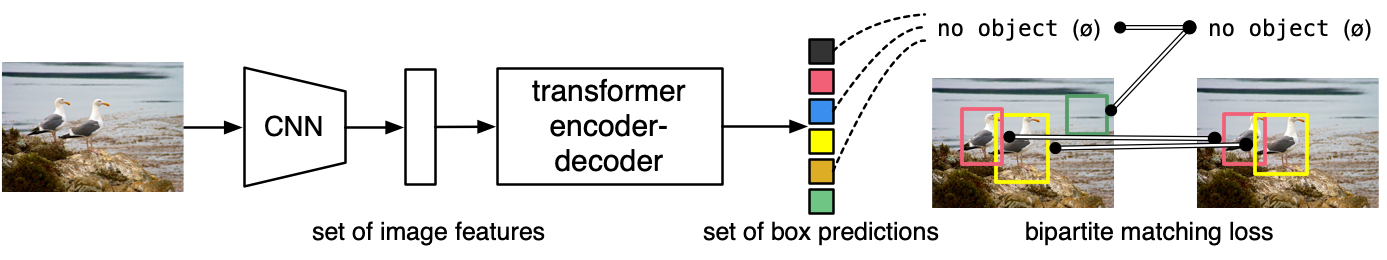

DEtection TRansformer (DETR) model trained end-to-end on COCO 2017 object detection (118k annotated images). It was introduced in the paper [End-to-End Object Detection with Transformers](https://arxiv.org/abs/2005.12872) by Carion et al. and first released in [this repository](https://github.com/facebookresearch/detr).

|

||||||

|

|

||||||

|

Disclaimer: The team releasing DETR did not write a model card for this model so this model card has been written by the Hugging Face team.

|

||||||

|

|

||||||

|

## Model description

|

||||||

|

|

||||||

|

The DETR model is an encoder-decoder transformer with a convolutional backbone. Two heads are added on top of the decoder outputs in order to perform object detection: a linear layer for the class labels and a MLP (multi-layer perceptron) for the bounding boxes. The model uses so-called object queries to detect objects in an image. Each object query looks for a particular object in the image. For COCO, the number of object queries is set to 100.

|

||||||

|

|

||||||

|

The model is trained using a "bipartite matching loss": one compares the predicted classes + bounding boxes of each of the N = 100 object queries to the ground truth annotations, padded up to the same length N (so if an image only contains 4 objects, 96 annotations will just have a "no object" as class and "no bounding box" as bounding box). The Hungarian matching algorithm is used to create an optimal one-to-one mapping between each of the N queries and each of the N annotations. Next, standard cross-entropy (for the classes) and a linear combination of the L1 and generalized IoU loss (for the bounding boxes) are used to optimize the parameters of the model.

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

## Intended uses & limitations

|

||||||

|

|

||||||

|

You can use the raw model for object detection. See the [model hub](https://huggingface.co/models?search=facebook/detr) to look for all available DETR models.

|

||||||

|

|

||||||

|

### How to use

|

||||||

|

|

||||||

|

Here is how to use this model:

|

||||||

|

|

||||||

|

```python

|

||||||

|

from transformers import DetrImageProcessor, DetrForObjectDetection

|

||||||

|

import torch

|

||||||

|

from PIL import Image

|

||||||

|

import requests

|

||||||

|

|

||||||

|

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

|

||||||

|

image = Image.open(requests.get(url, stream=True).raw)

|

||||||

|

|

||||||

|

processor = DetrImageProcessor.from_pretrained("facebook/detr-resnet-50")

|

||||||

|

model = DetrForObjectDetection.from_pretrained("facebook/detr-resnet-50")

|

||||||

|

|

||||||

|

inputs = processor(images=image, return_tensors="pt")

|

||||||

|

outputs = model(**inputs)

|

||||||

|

|

||||||

|

# convert outputs (bounding boxes and class logits) to COCO API

|

||||||

|

# let's only keep detections with score > 0.9

|

||||||

|

target_sizes = torch.tensor([image.size[::-1]])

|

||||||

|

results = processor.post_process_object_detection(outputs, target_sizes=target_sizes, threshold=0.9)[0]

|

||||||

|

|

||||||

|

for score, label, box in zip(results["scores"], results["labels"], results["boxes"]):

|

||||||

|

box = [round(i, 2) for i in box.tolist()]

|

||||||

|

print(

|

||||||

|

f"Detected {model.config.id2label[label.item()]} with confidence "

|

||||||

|

f"{round(score.item(), 3)} at location {box}"

|

||||||

|

)

|

||||||

|

```

|

||||||

|

This should output:

|

||||||

|

```

|

||||||

|

Detected remote with confidence 0.998 at location [40.16, 70.81, 175.55, 117.98]

|

||||||

|

Detected remote with confidence 0.996 at location [333.24, 72.55, 368.33, 187.66]

|

||||||

|

Detected couch with confidence 0.995 at location [-0.02, 1.15, 639.73, 473.76]

|

||||||

|

Detected cat with confidence 0.999 at location [13.24, 52.05, 314.02, 470.93]

|

||||||

|

Detected cat with confidence 0.999 at location [345.4, 23.85, 640.37, 368.72]

|

||||||

|

```

|

||||||

|

|

||||||

|

Currently, both the feature extractor and model support PyTorch.

|

||||||

|

|

||||||

|

## Training data

|

||||||

|

|

||||||

|

The DETR model was trained on [COCO 2017 object detection](https://cocodataset.org/#download), a dataset consisting of 118k/5k annotated images for training/validation respectively.

|

||||||

|

|

||||||

|

## Training procedure

|

||||||

|

|

||||||

|

### Preprocessing

|

||||||

|

|

||||||

|

The exact details of preprocessing of images during training/validation can be found [here](https://github.com/google-research/vision_transformer/blob/master/vit_jax/input_pipeline.py).

|

||||||

|

|

||||||

|

Images are resized/rescaled such that the shortest side is at least 800 pixels and the largest side at most 1333 pixels, and normalized across the RGB channels with the ImageNet mean (0.485, 0.456, 0.406) and standard deviation (0.229, 0.224, 0.225).

|

||||||

|

|

||||||

|

### Training

|

||||||

|

|

||||||

|

The model was trained for 300 epochs on 16 V100 GPUs. This takes 3 days, with 4 images per GPU (hence a total batch size of 64).

|

||||||

|

|

||||||

|

## Evaluation results

|

||||||

|

|

||||||

|

This model achieves an AP (average precision) of **42.0** on COCO 2017 validation. For more details regarding evaluation results, we refer to table 1 of the original paper.

|

||||||

|

### BibTeX entry and citation info

|

||||||

|

|

||||||

|

```bibtex

|

||||||

|

@article{DBLP:journals/corr/abs-2005-12872,

|

||||||

|

author = {Nicolas Carion and

|

||||||

|

Francisco Massa and

|

||||||

|

Gabriel Synnaeve and

|

||||||

|

Nicolas Usunier and

|

||||||

|

Alexander Kirillov and

|

||||||

|

Sergey Zagoruyko},

|

||||||

|

title = {End-to-End Object Detection with Transformers},

|

||||||

|

journal = {CoRR},

|

||||||

|

volume = {abs/2005.12872},

|

||||||

|

year = {2020},

|

||||||

|

url = {https://arxiv.org/abs/2005.12872},

|

||||||

|

archivePrefix = {arXiv},

|

||||||

|

eprint = {2005.12872},

|

||||||

|

timestamp = {Thu, 28 May 2020 17:38:09 +0200},

|

||||||

|

biburl = {https://dblp.org/rec/journals/corr/abs-2005-12872.bib},

|

||||||

|

bibsource = {dblp computer science bibliography, https://dblp.org}

|

||||||

|

}

|

||||||

|

```

|

||||||

|

|

@ -0,0 +1,31 @@

|

||||||

|

from sklearn.datasets import load_iris

|

||||||

|

from sklearn.model_selection import train_test_split

|

||||||

|

from sklearn.svm import SVC

|

||||||

|

import argparse

|

||||||

|

|

||||||

|

# 加载数据集

|

||||||

|

iris = load_iris()

|

||||||

|

X = iris.data

|

||||||

|

y = iris.target

|

||||||

|

|

||||||

|

# 划分数据集

|

||||||

|

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

|

||||||

|

|

||||||

|

# 参数解析

|

||||||

|

parser = argparse.ArgumentParser(description='SVM Model for Iris dataset')

|

||||||

|

parser.add_argument('--C', type=float, default=1.0, help='Regularization parameter')

|

||||||

|

parser.add_argument('--kernel', type=str, default='rbf', help='Kernel type')

|

||||||

|

parser.add_argument('--gamma', type=float, default='scale', help='Kernel coefficient')

|

||||||

|

|

||||||

|

args = parser.parse_args()

|

||||||

|

|

||||||

|

# 定义支持向量机模型并设置参数

|

||||||

|

svm = SVC(C=args.C, kernel=args.kernel, gamma=args.gamma)

|

||||||

|

|

||||||

|

# 在训练集上拟合模型

|

||||||

|

svm.fit(X_train, y_train)

|

||||||

|

|

||||||

|

# 输出模型在测试集上的准确率

|

||||||

|

test_accuracy = svm.score(X_test, y_test)

|

||||||

|

print(f"Accuracy={test_accuracy}")

|

||||||

|

|

||||||

|

|

@ -0,0 +1,31 @@

|

||||||

|

from sklearn.datasets import load_iris

|

||||||

|

from sklearn.model_selection import train_test_split

|

||||||

|

from sklearn.svm import SVC

|

||||||

|

import argparse

|

||||||

|

|

||||||

|

# 加载数据集

|

||||||

|

iris = load_iris()

|

||||||

|

X = iris.data

|

||||||

|

y = iris.target

|

||||||

|

|

||||||

|

# 划分数据集

|

||||||

|

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

|

||||||

|

|

||||||

|

# 参数解析

|

||||||

|

parser = argparse.ArgumentParser(description='SVM Model for Iris dataset')

|

||||||

|

parser.add_argument('--C', type=float, default=1.0, help='Regularization parameter')

|

||||||

|

parser.add_argument('--kernel', type=str, default='rbf', help='Kernel type')

|

||||||

|

parser.add_argument('--gamma', type=float, default='scale', help='Kernel coefficient')

|

||||||

|

|

||||||

|

args = parser.parse_args()

|

||||||

|

|

||||||

|

# 定义支持向量机模型并设置参数

|

||||||

|

svm = SVC(C=args.C, kernel=args.kernel, gamma=args.gamma)

|

||||||

|

|

||||||

|

# 在训练集上拟合模型

|

||||||

|

svm.fit(X_train, y_train)

|

||||||

|

|

||||||

|

# 输出模型在测试集上的准确率

|

||||||

|

test_accuracy = svm.score(X_test, y_test)

|

||||||

|

print(f"Accuracy={test_accuracy}")

|

||||||

|

|

||||||

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

Binary file not shown.

|

After Width: | Height: | Size: 12 MiB |

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

|

|

@ -0,0 +1,30 @@

|

||||||

|

bitahub模型库用例评审

|

||||||

|

1、模型库,排序列表中改成创建时间

|

||||||

|

2、"我发布的"改成"我创建的","发布模型"改成"创建模型"

|

||||||

|

3、部署量按版本累加

|

||||||

|

4、发布模型,支持模型体验始终开启

|

||||||

|

5、创建模型,默认的模型介绍文件和描述、内容待景祥确认

|

||||||

|

6、版本描述没有时不展示

|

||||||

|

7、文件点击,指定格式支持预览,待提供

|

||||||

|

.txt

|

||||||

|

.md(Markdown文件)

|

||||||

|

.json

|

||||||

|

.yaml 或 .yml

|

||||||

|

.py(Python脚本)

|

||||||

|

.log

|

||||||

|

jpg

|

||||||

|

jpeg

|

||||||

|

png

|

||||||

|

8、大文件(50M)预览限制待确认

|

||||||

|

9、上传同名文件不支持覆盖,上传时给出异常提示;增加删除按钮

|

||||||

|

10、后台强制下线的版本,模型库中不展示该版本,我的空间-我发布的中展示该版本,我收藏的不展示该版本;我的空间、模型库在线体验列表中不展示,我的空间状态展示为强制下线

|

||||||

|

11、我发布的,模型状态:未发布、已上线、强制下线、驳回、审核中

|

||||||

|

12、添加版本,选择分支默认为当前列表展示的版本,可切换

|

||||||

|

13、模型名规则:'86字符以内,支持1-86位字母、数字、点、中划线、下划线,不能以点、中划线开头'。版本号规则:'不超过64字符,支持由小写字符、数字和._-组成,不可以特殊字符开头和结尾,且特殊字符不可连续'

|

||||||

|

14、添加版本,版本信息支持字符串,仅限制100个字符

|

||||||

|

15、上传文件,使用通用组件,目前仅支持根目录上传,限制50M

|

||||||

|

16、上传文件,文件信息支持字符串,仅限制200个字符

|

||||||

|

17、md文件大小校验?跟以前保持一致

|

||||||

|

18、创建模型,去除暂存按钮

|

||||||

|

19、后台审核,同步状态:成功(运行状态)、部署失败

|

||||||

|

20、后台审核。支持历史操作列表

|

||||||

Binary file not shown.

|

After Width: | Height: | Size: 37 MiB |

Loading…

Reference in New Issue